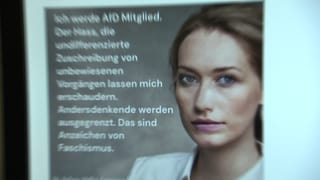

Die AfD in Göppingen nutzt Künstliche Intelligenz, um mit technisch generierten Gesichtern und Bildern Wahlkampf zu machen. Eine blonde Frau mit Doktortitel, die in einem Post auf Instagram Dr. Stefanie Müller genannt wird, erklärt, warum sie Mitglied der AfD geworden ist. Verboten ist solche Wahlwerbung zwar nicht, sie wirft aber doch Fragen auf.

Das geschulte Auge erkennt, dass mit dem Bild dieser Stefanie Müller etwas nicht stimmen kann. Das Urteil von Marco Huber, KI-Experte am Fraunhofer Institut in Stuttgart, fällt eindeutig aus. Auf die Frage, mit welcher Wahrscheinlichkeit das Bild gefälscht ist, sagt er:

Da bin ich mir zu 100 Prozent sicher. Also das ist ein relativ schlechtes Bild. Da hat man sich wenig Mühe gegeben oder vielleicht auch ein altes KI-System genutzt.

So erkennt man Bilder, die mit KI erstellt wurden

KI-Experte Marco Huber von der Abteilung Cyber Cognitive Intelligence am Fraunhofer Institut in Stuttgart erklärt detailliert, was ihn zu dieser Einschätzung kommen lässt. "Die Fältchen am Auge sind sehr unnatürlich. Und sehr häufig sieht man es an den Pupillen. Die sind beim Menschen sehr rund, das sind sie in diesem Fall nicht." Normalerweise sehe man auch Glanzpunkte, also kleine Lichtpunkte in den Augen. Diese seien bei einem realen Bild symmetrisch. Beim Bild von Stefanie Müller sei das nicht der Fall. Des Weiteren seien die Übergänge zwischen Haut und Lippen, die Form der Oberlippe und der Kragen vom Hemd unnatürlich. Der Experte ist sich sicher: Dieses Bild wurde künstlich generiert.

AfD bestreitet Nutzung von KI nicht

Sandro Scheer, der Vorsitzende des AfD-Kreisverbandes Göppingen, bestätigte auf SWR-Anfrage, dass die Partei Künstliche Intelligenz zur Erstellung von Bildern nutzt.

Selbstverständlich verwenden wir bei personenbezogenen Daten Beispielbilder, auch mal KI-basiert.

Scheers Begründung: "In einer Zeit, in der AfD-Mitglieder oder Wirte, die für AfD-Veranstaltungen ihre Räume zur Verfügung stellen, angegriffen oder bedroht werden, deren Häuser beschmiert oder Radschrauben gelockert werden, können und wollen wir unsere Neumitglieder nicht einer entsprechenden Gefahr aussetzen." Ob es konkret eine Dr. Stefanie Müller in den Reihen der AfD Göppingen gibt, das ließ Sandro Scheer in seiner Antwort allerdings offen.

AfD-Mitglied Stefanie Müller gibt es zumindest in dieser Form nicht

Fakt ist: Die Frau, wie sie auf dem Bild dargestellt ist, gibt es in dieser Form nicht. Nicht nur Marco Huber vom Stuttgarter Fraunhofer Institut kommt zu diesem Ergebnis. Auch Carsten Rother vom Computer Vision und Learning Lab der Universität Heidelberg bestätigt das. "Der Scheitel hat eine viel zu klare Kante. Die Pupillen haben unterschiedliche Formen. Es gibt mit sehr großer Wahrscheinlichkeit keine Kamera, die so ein Bild aufnehmen kann, da runde Pupillen sich nicht beliebig verformen können in unterschiedlichen Bereichen des Bildes. Das widerspricht dem Gesetz einer perspektiven Projektion."

KI bei der AfD nicht nur für künstlich generierte Mitglieder

Die AfD setzt nicht nur im Kreis Göppingen Künstliche Intelligenz zur Erstellung von Bildern ein. Auch im Landkreis Esslingen warb man pünktlich zum Start des Fastenmonats Ramadan mit einem KI-generierten Bild für ein "deutsches Grillfest". Auch die AfD-Fraktion Baden-Württemberg verbreitet immer wieder Bilder, die eine falsche Realität darstellen. Vom schwer bewachten Weihnachtsmarkt unter Stacheldraht, über einen arabisch-stämmigen Mann mit Bankkarte bis hin zum vermeintlich zerstörten Feldberg. Die Partei, die immer wieder betont, gegen Fake-News vorgehen zu wollen, setzt selbst vermehrt auf falsch dargestellte Realitäten.

KI-generiertes Foto Eigentor für AfD Esslingen? "Zombies" bei "deutschem" Grillfest

Die AfD Esslingen ruft auf Facebook zum Essen von Schweinefleisch auf parallel zum islamischen Fastenmonat. Neben Zustimmung gibt es im Netz Häme wegen des KI-generierten Bildes.

Der Co-Vorsitzende des Landesverbands der AfD in Baden-Württemberg, Markus Frohnmaier, sieht darin kein Problem. Über das Bild aus Göppingen sagt er: "Ich glaube, es ist offenkundig, dass es KI generiert ist, das sieht man ja auch, wenn man sich das anschaut. Aber ich finde die Idee dahinter interessant und ja, mal schauen, was man da an kreativen Dingen im Wahlkampf sehen kann."

Täuschung des Wählers kein Straftatbestand

Sind solche künstlich generierten Bilder im Wahlkampf und der politischen Meinungsbildung rechtens? Oder stellen sie gar einen Straftatbestand dar? Tun sie nicht, sagt Kolja Schwarz aus der ARD-Rechtsredaktion. "Die Beeinflussung von Wählern durch Informationen, die nicht stimmen oder im Speziellen durch Fotos, die eine Künstliche Intelligenz erstellt hat, ist in Deutschland nicht strafbar." Es werde aber zumindest diskutiert, das zu ändern, weil immer mehr Inhalte durch KI erstellt werden.

Strafbar ist es schon jetzt, wenn man Fotos von realen Personen nur verändert und ohne ihr Einverständnis veröffentlicht.

Bilder mit Künstlicher Intelligenz: Gefahr für die Demokratie

Bilder beeinflussen die Wahrnehmung und die Rezeption von Informationen. Damit greifen sie stark in die Meinungsbildung ein und sind damit ein elementarer Bestandteil von politischer Informationsvermittlung und greifen auch in das Abstimmungsverhalten von Wählern ein.

Jutta Jahnel forscht am Karlsruher Institut für Technologie (KIT) zu digitalen Technologien und dem gesellschaftlichen Wandel, der mit diesen einhergeht. Von künstlich generierten Bildern gehe eine Gefahr für die Demokratie aus, sagt sie. Es sei problematisch, wenn es um den Diskurs und die Meinungsbildung, aber auch um Wahlen oder die Kommunikation im Allgemeinen gehe. "Das heißt, wir haben hier auch zunehmend ein Instrument, wo man auch mehr Polarisierung in der Kommunikation einsetzen kann und zum Beispiel auch einzelne Personen dann schlechter darstellen kann - wie zum Beispiel Politiker."

KI und Deepfakes fördern das Misstrauen in Nachrichten

Manipulation sei dabei das eine, das andere, betont sie, sei das generelle Misstrauen in der Gesellschaft. Das steige durch solche künstlich generierten Bilder an und richte sich in der Folge gegen jegliche Art der Nachrichten, Bilder und Institutionen - auch gegen richtige.

Gerade in der Demokratie ist es wichtig, dass man sich auf authentische Informationen verlassen kann.

Moderne Systeme mit Künstlicher Intelligenz werden immer besser

Marco Huber vom Fraunhofer Institut in Stuttgart sagt, im Moment könne man künstlich generierte Gesichter noch erkennen. Aber man müsse davon ausgehen, dass die KI-Qualität besser werde. Schon jetzt seien beim Einsatz von neuen, hochwertigen Programmen kaum mehr Unterschiede zu realen Gesichtern auszumachen. "Und dann können sie sich vorstellen, dass man einem Politiker eine Rede andichtet, die er so nicht gehalten hat."

Hubers Lösung: "Bildung, Bildung, Bildung." Man müsse früh lernen, Deepfakes wie solche künstlich generierten Bilder zu identifizieren und zu unterscheiden, sagt der KI-Experte. Dieses Lernen fange in der Schule an. Seiner Meinung nach sei ein generelles Verbot von Künstlicher Intelligenz deshalb der falsche Weg, erst recht an Schulen.