Der KI-Podcast von BR24 und SWR ist in einem KI-Experiment zu einem verblüffenden Ergebnis gekommen: Das KI-Modell GPT-4o, das viele aus ChatGPT kennen, hat in einem Test 29 von 30 Prüfungsfragen für die Führerscheinzulassung Klasse B richtig beantwortet – und hätte den Test damit bestanden. Und das, obwohl die KI zuvor nicht explizit für diese Aufgabe trainiert wurde.

Der Schlüssel zum Erfolg für den Chatbot: Die KI gibt die Antwort nicht einfach sofort, sondern geht die Antwortmöglichkeiten nacheinander durch und wägt für jede individuell ab, ob diese als Lösung in Frage kommt. Erst ganz am Ende seines Outputs entscheidet sich ChatGPT für eine Antwort. Diese Technik, auch "Chain of Thought" genannt, ist auch ein wichtiger Bestandteil von OpenAIs neuem KI-Modell o1. o1 kann jedoch bislang nur Text und keine Bilder verarbeiten.

So lief das Experiment zur theoretischen Führerscheinprüfung ab

Für das Experiment wurde das KI-Modell GPT-4o verwendet – das aktuelle multimodale Modell von ChatGPT. Eine multimodale KI kann mit verschiedenen Medien umgehen, etwa Text- und Bildmaterial.

Anschließend wurden der KI dreißig originale Fragen in Form von Screenshots aus dem Fragenkatalog gestellt. Zusammengenommen ergaben diese einen typischen Prüfungsbogen der Klasse B – ein Test, bei dem im Schnitt fast jeder zweite Fahrschüler in Baden-Württemberg und Rheinland-Pfalz durchfällt.

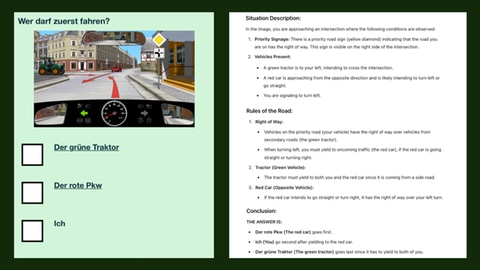

Bei Fragen mit Bild wurden die Bilder als hochaufgelöste Screenshots zur Verfügung gestellt, bei Fragen mit kurzen Videoclips wurden in der Regel mehrere Screenshots gemacht.

Die KI erhielt keine zusätzlichen Informationen zu Prüfungsfragen, Verkehrsregeln oder ähnlichem, musste sich also mit dem Wissen behelfen, das bereits im Modell enthalten ist. Auch auf das Internet konnte ChatGPT nicht zugreifen. ChatGPT befolgte die Anweisungen – und gab auf Englisch seine Einschätzung ab.

ChatGPT zeigt Stärke in Technik und Recht

Bei beinahe allen Fragen gab ChatGPT die richtige Antwort. Besonders sicher war der Chatbot bei Fragen rund um Fahrzeugtechnik und rechtlicher Sachverhalte – also Bereiche, in denen sich menschliche Fahrschüler oft schwer tun.

Auch die Ausführungen, mit denen ChatGPT seine Antworten begründet, waren in der Regel fundiert und ausführlich. Bei der Frage "Wovon ist der Bremsweg abhängig?" nennt ChatGPT nicht nur korrekt die drei richtigen Antworten "Fahrbahnoberfläche", "Bremsanlage" und "Bereifung", sondern wird konkret in seiner Erklärung: "Der Zustand der Reifen, einschließlich der Profiltiefe und des Reifendrucks, hat großen Einfluss auf die Fähigkeit des Fahrzeugs, auf der Straße zu haften, und folglich auf den Bremsweg."

Hat ChatGPT heimlich gepaukt?

"Wenn man die Begründungen liest, bekommt man schon das Gefühl, dass ChatGPT logisch an die Sache herangeht", meint der Münchner Fahrlehrer Maximilian Hitzler zu den Antworten des Chatbots. "Als würde dieser Chatbot wirklich gerade seinen Führerschein machen und hätte das Theoriebuch gelesen."

Eine KI wie ChatGPT kann zwar nicht so lernen, wie das ein Mensch macht. Trotzdem könnte die KI in gewisser Weise das Theoriebuch "gelesen" haben. Denn tatsächlich sind viele der Prüfungsfragen im Internet abrufbar. Auch wenn die KI von der Redaktion nicht explizit auf die Fragen vorbereitet wurde, ist es möglich, dass sich einige der Prüfungsfragen bereits in den Trainingsdaten befanden – ein Vorteil für die KI.

Allerdings: Die Antworten von ChatGPT waren nur dann gut, wenn die KI sich selbst Zeit zum "Nachdenken" gab. Bei dieser Technik, auch "Chain of Thought-Prompting" genannt, geht die KI die Frage und alle Elemente darin Stück für Stück durch und gibt erst am Ende eine Einschätzung ab.

Bittet man ChatGPT darum, sofort die Lösung zu geben, werden die Ergebnisse deutlich schlechter. Das ist ein Hinweis darauf, dass die KI nicht einfach nur nachplappert, sondern sich die korrekte Antwort tatsächlich "erschließt".

Im Erkennen von Bildern zeigt ChatGPT Schwächen

Allerdings kann die KI offensichtlich auch mehr als nur auswendig lernen. Das zeigt sich in ihren Antworten auf Bild-Fragen – bei denen ChatGPT manchmal etwas haarsträubende Interpretationen liefert, am Ende aber trotzdem fast immer zum richtigen Ergebnis kommt.

Dieses komplexe Analysieren von Verkehrsteilnehmern, Personen und Abständen auf den Bildern ist keine leichte Aufgabe – noch vor wenigen Monaten ist ChatGPT in einem früheren Test an der Aufgabe gescheitert. Heute werden praktisch alle Verkehrsteilnehmer zuverlässig erkannt, und die Fragen richtig beantwortet.

Dennoch kommt es bei der Bilderkennung immer wieder zu Problemen. In den Erklärungen versetzt ChatGPT gelegentlich Verkehrsschilder an andere Stellen, oder erfindet Fahrstreifen hinzu, die nicht da sind. Besonders kritisch ist es bei der einzigen Frage, die ChatGPT falsch beantwortet: Hier macht die KI aus einer abknickenden Vorfahrsstraße eine normale Vorfahrtsstraße – und schätzt deshalb die Vorfahrt falsch ein. Ein kolossaler Fehler – den ein Mensch wohl kaum gemacht hätte.

"Auf der Straße hätte er sehr viele Schwierigkeiten"

Ist ChatGPTs künstliche Intelligenz damit schon auf dem Level eines Menschen? Fahrlehrer Maximilian Hitzler ist sich unsicher: "Ich habe auch mit echten Fahrschülern manchmal die Erfahrung gemacht: Die hatten null Fehler in der Theorieprüfung. Aber auf der Straße will man denen nicht begegnen."

Etwa in diesem Bereich würde sich auch die KI bewegen. Wäre sie ein echter Schüler, wären zwar ihre Antworten richtig, aber ihre Gedankengänge zu konfus. "Ich würde ChatGPT als jemanden einordnen, der in Theorie sehr gut an die Sache rangeht und sich sehr viele Gedanken macht. Aber auf der Straße hätte er sehr viele Schwierigkeiten."

Rasanter Fortschritt bei KI-Modellen wie ChatGPT

Trotz des Experiments: ChatGPT ist nicht so intelligent wie ein echter Fahrschüler – und sicher nicht bereit dafür, in Roboterform in den Straßenverkehr geschickt zu werden.

Dennoch zeigt sich an dem einfachen Experiment der rasante Fortschritt in der Welt der KI. Noch vor kurzem hätten einen solchen Test nur besonders spezialisierte Systeme bestehen können. Heute schafft ihn sogar eine Allzweck-KI wie GPT-4o. Diese KI-Modelle können oft weit mehr als von ihnen erwartet wird – und Experimente wie dieses demonstrieren ihre Fähigkeiten und Schwächen. Einige andere KI-Modelle wurden ebenfalls dem Test unterzogen – und fielen durch.

Es ist nicht das erste Mal, dass eine KI mit einem bestandenen Test für Furore sorgt. Erst letztes Jahr hatte ChatGPT in einem Test des BR das bayerische Abitur geknackt.