Der Einsatz von Künstlicher Intelligenz soll künftig in der EU mit dem sogenannten AI-Act geregelt werden. Kann das neue KI-Gesetz die möglichen Gefahren Künstlicher Intelligenz verringern? Eine Einschätzung von David Beck aus der SWR-Wissenschaftsredaktion.

Während einige Details des AI-Acts noch offen sind, sind die größten Streitpunkte vom Tisch geräumt – etwa was die Regulierung von sogenannten Grundlagenmodellen angeht. Das sind KI-Modelle, auf denen eine Vielzahl verschiedener Anwendungen gebaut werden können. Dazu gehört zum Beispiel GPT-4 von Open-AI, auf dem der Chatbot Chat-GPT basiert.

Wie sich Künstliche Intelligenz weiter entwickeln wird, ist schwer vorhersehbar

Vieles am AI-Act wird gut und ist als Erfolg für die Grundrechte der Europäerinnen und Europäer zu werten – aber er darf nicht als endgültig angesehen werden. Dafür wissen wir einfach noch zu wenig darüber, wie sich die KI-Revolution weiterentwickeln wird.

Das sehen wir schon daran, dass der ursprüngliche risikobasierte – und damit vermeintlich zukunftssichere Ansatz des AI-Acts bei sogenannten Grundlagenmodellen auf einmal nicht mehr funktioniert. Eigentlich sollte der Anwendungszweck von KI reguliert werden, nicht jede Anwendung selbst.

Grundlagenmodelle, zum Beispiel GPT-4, auf dem Chat-GPT basiert, können für verschiedenste Zwecke eingesetzt werden. Das hätte eine Regulierung nach der ursprünglichen Idee schwierig bis unmöglich gemacht.

KI-Gesetz kann dabei helfen, Risiken zu verringern

Dass diese Modelle jetzt speziell reguliert werden, ist aber gut. So kann das Risiko der Anwendungen, die daraus entstehen schon mal deutlich gesenkt werden. Sandra Wachter, Professorin für Technologie und Regulierung an der Universität Oxford, beschreibt es treffend:

Kommt aus dem Hahn giftiges Wasser, ist es besser, die Quelle zu säubern, als in jedem Haus Filter einzubauen.

Industrieverbände kritisieren, dass so die Innovations- und Wettbewerbsfähigkeit beschränkt wird. Allerdings gelten diese Regeln nicht nur für europäische Unternehmen, sondern für alle, die ihre Produkte in Europa vermarkten wollen. Will Open-AI also zum Beispiel weiter am europäischen Markt bleiben, werden ihre Modelle in Zukunft AI-Act-konform sein müssen.

EU kann Unternehmen zur Einhaltung bestimmter Regeln zwingen

Dass die EU interessant genug ist, um selbst den größten Technologie-Unternehmen Regeln aufzwingen zu können, haben wir bei Apple gesehen: Seit Ladekabel für Handys hier standardisiert sein müssen, hat das Unternehmen das iPhone vom eigenen Lightning-Kabel auf den Standard USB-C umgestellt.

Das Gesetz enthält aber auch Punkte, die am Ende nicht reichen werden, um unsere Rechte ausreichend zu schützen. Open-Source-Modelle, deren Programmcode für alle offen einsehbar ist, sind zum Beispiel von der Grundlagenmodellregulierung größtenteils ausgenommen.

Das kommt zur Zeit vor allem dem Facebook-Mutterkonzern Meta zugute, der sein eigenes Sprachmodell Llama unter einer Open-Source-Lizenz anbietet.

AI-Act zur Regulierung Künstlicher Intelligenz bietet auch Schlupflöcher

Dass Gesichts- und Emotionserkennung in bestimmten Situationen erlaubt ist, bietet Schlupflöcher und die große Aufmerksamkeit des Gesetzes auf Hochrisikosysteme lässt viele kleine Anwendungen, von denen nur ein kleines Risiko ausgeht, praktisch unreguliert.

Am Ende wissen wir auch überhaupt gar nicht, was uns die KI-Entwicklung noch alles bringt. Vielleicht ist nach dem nächsten großen Ding das ganze Gesetz schon wieder hinfällig.

Irgendjemand muss aber damit anfangen, KI zu regulieren und es ist gut, dass es die EU ist. Bleibt zu hoffen, dass die Gesetzgebung flexibel genug ist, um sich der neuen Realität anpassen zu können, die mit KI auf uns zukommt.

Mehr zum Thema Künstliche Intelligenz

Künstliche Intelligenz: ChatGPT im Journalismus Kommentar: Axel Springer-Verlag und OpenAI gehen Partnerschaft ein

Open AI und Axel Springer haben eine Kooperation vereinbart. Welche Risiken bietet die Zusammenarbeit? Was bedeutet das für die Nachrichtengebung? Stefan Troendle kommentiert.

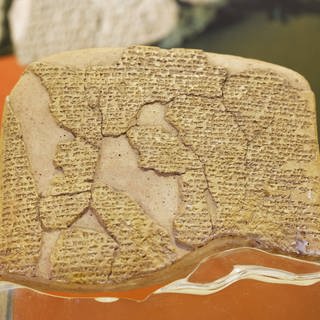

Künstliche Interelligenz in der Archäologie KI erleichtert die Entschlüsselung von Keilschrifttafeln

Jahrtausende alte Tontafeln haben uns Hochkulturen wie die Babylonier hinterlassen. Künstliche Intelligenz entschlüsselt die komplexe Keilschrift jetzt schneller und zuverlässiger.

Künstliche Intelligenz Gefakte Tagesschau-Audiodateien im Umlauf

Mithilfe von Künstlicher Intelligenz lassen sich immer leichter Stimmen fälschen. EIn aktuelles Beispiel sind Audiodateien, in denen die Stimmen der Tagesschau-Sprecherin Susanne Daubner und des Tagesschau-Sprecher Jens Riewa geklont wurden. Wie funktionieren solche Fälschungen und wie können sie erkannt werden?